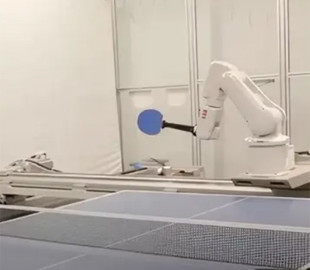

Робот від DeepMind обіграв людей у половині матчів з настільного тенісу

Дослідники з Google DeepMind створили першого у світі роботизованого гравця у настільний теніс, здатного грати на рівні любителя. Система поєднує промисловий робот-маніпулятор ABB IRB 1100 і спеціалізоване програмне забезпечення від DeepMind. Робот виграв 45% із 29 зіграних ігор. Він переміг усіх новачків та виграв 55% матчів проти гравців середнього рівня. Хоча професійний гравець все ще може перемогти робота, система демонструє потенціал машин у освоєнні складних фізичних завдань, що потребують миттєвого прийняття рішень та адаптації.

Фізична установка складається з промислового робота-маніпулятора IRB 1100 із шістьма ступенями свободи, змонтованого на двох лінійних напрямних, що забезпечує його вільне переміщення у двовимірній площині. Високошвидкісні камери фіксують положення м'яча, а система захоплення руху відстежує переміщення ракетки людини-суперника. Щоб створити «мозок» для роботизованої руки, дослідники DeepMind розробили двоступінчасту систему, яка дозволяє роботу не тільки виконувати окремі технічні прийоми в настільному тенісі, але й гнучко адаптуватись до стилю гри кожного конкретного суперника в режимі реального часу. Це означає, що робота не потребує спеціальної підготовки для кожного нового гравця.

Архітектура системи побудована на двох рівнях: низькорівневих контролерах навичок та високорівневому стратегічному блоці. Контролери низького рівня представлені нейронними мережами, які відповідають за виконання конкретних прийомів настільного тенісу, наприклад, відповіді на подачу. Стратегічний блок — складніша система штучного інтелекту, яка аналізує поточний стан гри, адаптується до стилю гри суперника і вибирає, яку з низькорівневих навичок необхідно активувати для обробки кожного наступного удару.

Однією із ключових інновацій цього проекту став метод навчання моделей ШІ.

Дослідники застосували гібридний підхід, комбінуючи навчання із підкріпленням у симульованому фізичному середовищі з навчанням на реальних даних. Це дозволило роботу ефективно вчитися на відносно невеликому наборі даних, що включає 17500 реальних траєкторій польоту м'яча.

Для вдосконалення навичок робота знадобилося кілька ітерацій. Після навчання на наборі даних про ігри для людей штучному інтелекту дозволили змагатися з реальними противниками. Кожен матч генерував нові дані про траєкторії м'яча та стратегії людини, які команда повертала у симуляцію для подальшого навчання. Цей процес, що повторювався сім разів, дозволив роботу постійно підлаштовуватися під суперників зростаючого рівня майстерності та різноманітних стилів гри.

До фінального раунду ШІ вивчив понад 14 000 розіграшів м'ячів та 3000 подач. Робот зібрав цілу базу знань з настільного тенісу, яка допомогла йому подолати розрив між симуляцією та реальністю.

Крім технічних аспектів дослідження також вивчало людський досвід гри проти штучного інтелекту. Дивно, але навіть гравці, які програли роботу, повідомили про позитивні враження. У всіх групах учасників, незалежно від результатів матчів, люди зійшлися на думці, що гра з роботом була «веселою» та «захоплюючою». Цей позитивний відгук передбачає застосування штучного інтелекту під час тренувань та індустрії розваг.

Система поки що не ідеальна. Їй складно впоратися зі швидкими або високими м'ячами, а також із сильним обертанням. У неї також виникають проблеми із ударами зліва. Наприклад, у відеоролику від DeepMind видно, як штучний інтелект не встигає за швидким ударом суперника. Дослідники наголошують, що за подальшого розвитку система зможе змагатися з професійними гравцями у настільний теніс. DeepMind вже має досвід створення моделей штучного інтелекту, здатних перемагати людей у різних іграх, таких як AlphaZero та AlphaGo.