Прагнення Google до перемоги в області ШІ призвело до етичних помилок

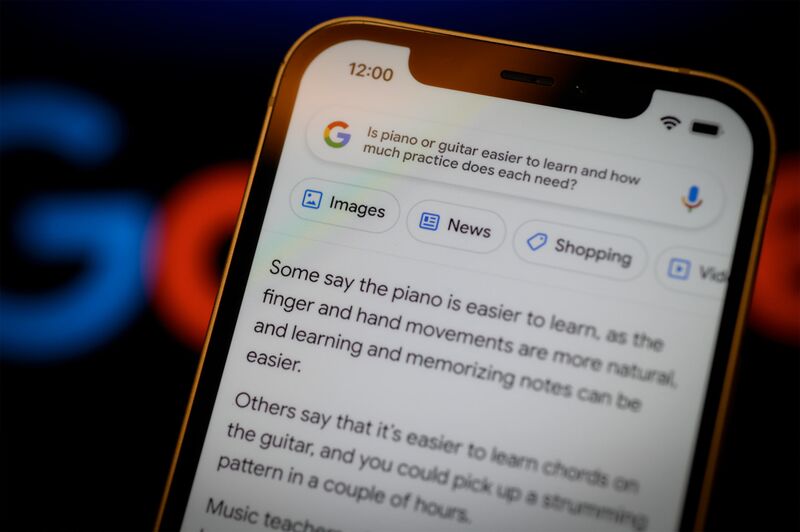

Незадовго до того, як у березні Google представив громадськості Bard, свій чат-бот зі штучним інтелектом, він попросив своїх співробітників протестувати інструмент.

Висновок одного працівника: Бард був «патологічним брехуном», згідно зі скріншотами внутрішньої дискусії. Інший назвав це "здригатися". Один із співробітників писав, що коли вони запитували Барда про те, як посадити літак, він регулярно давав поради, які призвели б до катастрофи; інший сказав, що він дає відповіді на підводне плавання, «яке може призвести до серйозних травм або смерті».

Google все одно запустив Bard. Надійний гігант інтернет-пошуку надає інформацію низької якості в змаганні за те, щоб не відставати від конкуренції, водночас приділяючи меншу увагу своїм етичним зобов’язанням, стверджують 18 нинішніх і колишніх працівників компанії та внутрішня документація, перевірена Bloomberg. Компанія, що належить Alphabet Inc., у 2021 році пообіцяла подвоїти свою команду, яка вивчає етику штучного інтелекту, і направити більше ресурсів на оцінку потенційної шкоди цієї технології. Але дебют у листопаді 2022 року популярного чат-бота конкурента OpenAI змусив Google за лічені місяці вплести генеративний ШІ у всі свої найважливіші продукти.

Це був помітно швидший темп розвитку технології, який міг мати глибокий вплив на суспільство. Зараз нинішні та колишні працівники заявили, що група, яка працює над етикою, яку Google зобов’язався зміцнити, позбавлена повноважень і деморалізована. Співробітникам, які відповідають за безпеку та етичні наслідки нових продуктів, було сказано не заважати та не намагатися знищити будь-які генеративні інструменти штучного інтелекту, що розробляються, вони сказали.

Google прагне оживити свій пошуковий бізнес, що розвивається, завдяки передовій технології, яка може запровадити генеративний штучний інтелект у мільйони телефонів і будинків по всьому світу — в ідеалі до того, як OpenAI за підтримки Microsoft Corp. перевершить компанію.

«Етика штучного інтелекту відійшла на другий план», — сказала Мередіт Віттакер, президент Signal Foundation, яка підтримує приватні повідомлення, і колишній менеджер Google. «Якщо етика не має переваги над прибутком і зростанням, вона в кінцевому підсумку не спрацює».

У відповідь на запитання Bloomberg Google сказав, що відповідальний штучний інтелект залишається головним пріоритетом компанії. «Ми продовжуємо інвестувати в команди, які працюють над застосуванням наших принципів штучного інтелекту до нашої технології», — сказав Брайан Габріель, прес-секретар. Команда, яка працює над відповідальним штучним інтелектом, звільнила щонайменше трьох співробітників у січневі звільнення в компанії, включаючи керівника управління та програм. Скорочення торкнулися близько 12 000 працівників Google і її материнської компанії.

Google, який протягом багатьох років очолював більшість досліджень, що лежать в основі сучасних досягнень штучного інтелекту, ще не інтегрував зручну для споживача версію генеративного штучного інтелекту у свої продукти до моменту запуску ChatGPT. За словами співробітників, компанія обережно ставилася до своєї влади та етичних міркувань, які йдуть пліч-о-пліч із впровадженням технології в пошукові та інші продукти для пошуку.

До грудня вище керівництво оголосило конкурентний «червоний код» і змінило свою схильність до ризику. За словами співробітників, керівники Google вирішили, що поки вони будуть називати нові продукти «експериментами», громадськість може пробачити їхні недоліки. Тим не менш, йому потрібно було залучити до роботи команди з етики. Того місяця керівник управління штучним інтелектом Джен Геннаї скликав зустріч відповідальної інноваційної групи, яка відповідає за дотримання принципів ШІ компанії.

Геннаї припустив, що, можливо, знадобляться певні компроміси, щоб прискорити випуск продуктів. Компанія призначає бали своїм продуктам у кількох важливих категоріях, призначених для вимірювання їх готовності до випуску для громадськості. У деяких випадках, як-от безпека дітей, інженерам ще потрібно подолати 100% поріг. Але Google може не мати часу чекати досконалості в інших сферах, порадила вона під час зустрічі. «Справедливості може бути не так, ми повинні досягти 99 відсотків», — сказав Геннаї, посилаючись на його термін для зменшення упередженості в продуктах. «З точки зору «справедливості» ми можемо мати 80, 85 відсотків або щось таке», щоб цього було достатньо для запуску продукту, додала вона.

У лютому один співробітник порушив питання у внутрішній групі повідомлень: «Bard гірше, ніж марний: будь ласка, не запускайте». Замітку переглянули майже 7000 людей, багато з яких погодилися, що відповіді інструменту ШІ були суперечливими або навіть кричущо неправильними на прості фактичні запити.

Наступного місяця Геннаї скасувала оцінку ризику, подану членами її команди, заявивши, що Бард не був готовий, оскільки це могло завдати шкоди, за словами людей, знайомих із цим питанням. Незабаром після цього Bard відкрили для публіки, а компанія назвала це «експериментом». .

У заяві Геннаї сказала, що це було не тільки її рішення. Після оцінки команди вона сказала, що «додала до списку потенційних ризиків від рецензентів і передала результат аналізу» групі старших керівників у продуктах, дослідженнях і бізнесі. Потім ця група «визначила, що доцільно просуватися до обмеженого експериментального запуску з продовженням попередньої підготовки, покращеними огорожами та відповідними застереженнями», — сказала вона.

Але видатний дебют ChatGPT означав, що на початку цього року шляху назад не було. У лютому Google почав блискавично анонсувати продукти генеративного штучного інтелекту, рекламуючи чат-бота Bard, а потім відеосервіс компанії YouTube, який заявив, що творці незабаром зможуть віртуально міняти одяг у відео або створювати «фантастичні налаштування фільму» за допомогою генеративного штучного інтелекту. Через два тижні Google анонсувала нові функції штучного інтелекту для Google Cloud, показуючи, як користувачі документів і презентацій зможуть, наприклад, створювати презентації та навчальні документи з продажів або чернетки електронних листів. Того ж дня компанія ім повідомилащо він буде вплітати генеративний штучний інтелект у свої пропозиції в галузі охорони здоров’я. Співробітники кажуть, що вони стурбовані тим, що швидкість розробки не дає достатньо часу для вивчення потенційної шкоди.

Проблема розробки передового штучного інтелекту в етичній манері вже давно викликає внутрішні дебати. Протягом останніх кількох років компанія зіткнулася з гучними помилками, включаючи незручний інцидент у 2015 році, коли її служба Photos помилково позначила зображення чорношкірого розробника програмного забезпечення та його друга як «горил».

Через три роки компанія заявила, що не виправила базову технологію штучного інтелекту, а натомість видалила всі результати пошуку за термінами «горила», «шимпанзе» та «мавпа», рішення, яке, за її словами, «розрізнена група експертів» зважений на. Компанія також створила етичний підрозділ штучного інтелекту, якому доручено проводити проактивну роботу, щоб зробити ШІ більш справедливим для своїх користувачів.

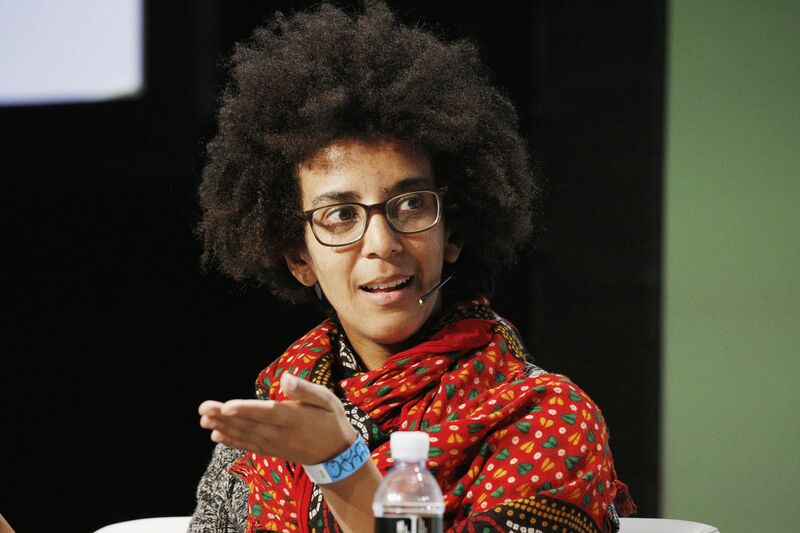

Але значним поворотним моментом, за словами понад дюжини нинішніх і колишніх співробітників, стало усунення дослідників штучного інтелекту Тімніта Гебру та Маргарет Мітчелл, які очолювали групу етичних штучних інтелектів Google, поки їх не витіснили в грудні 2020 року та лютому 2021 року через суперечка щодо справедливості досліджень ШІ компанії. Семі Бенджіо, комп’ютерний вчений, який керував роботою Гебру та Мітчелла, а також кілька інших дослідників у наступні роки пішли до конкурентів .

Після скандалу Google намагався поліпшити свою суспільну репутацію. Відповідальну групу штучного інтелекту було реорганізовано під керівництвом Маріан Кроак, тодішнього віце-президента з розробки. Вона пообіцяла подвоїти команду з етики ШІ та зміцнити зв’язки групи з рештою компанії.

Навіть після публічних заяв декому було важко працювати над етичним ШІ в Google. Один колишній співробітник сказав, що вони попросили попрацювати над справедливістю в машинному навчанні, але їх регулярно не заохочували — до такої міри, що це вплинуло на оцінку ефективності. Менеджери запротестували, що це заважає їхній «справжній роботі», — сказала особа.

Ті, хто залишився працювати над етичним штучним інтелектом у Google, залишилися сумніватися, як виконувати роботу, не піддаючи своїй роботі ризику. «Це був страшний час», — сказав Ньялленг Муросі, колишній науковий співробітник компанії, який зараз є старшим науковим співробітником Інституту розподілених досліджень ШІ , заснованого Gebru. Виконання етичної роботи зі штучним інтелектом означає, що «вас буквально найняли сказати: я не думаю, що це готове населення», – додала вона. «І таким чином ви сповільнюєте процес».

За словами двох співробітників, на сьогодні етичні перевірки продуктів і функцій штучного інтелекту є майже повністю добровільними в компанії, за винятком дослідницьких статей і процесу перевірки, який проводить Google Cloud щодо угод з клієнтами та продуктів для випуску. Дослідження штучного інтелекту в делікатних сферах, як-от біометрія, особливості ідентифікації або діти, проходять обов’язкову перевірку «делікатних тем» командою Геннаї, але інші проекти не обов’язково отримують етичні перевірки, хоча деякі співробітники звертаються до етичної команди штучного інтелекту, навіть якщо це не потрібно .

І все-таки, коли співробітники команд Google із розробки продуктів та інженерів шукають причину, через яку компанія повільно виводить на ринок штучний інтелект, зазвичай виникає публічна прихильність до етики. Дехто в компанії вважав, що нова технологія має бути доступна громадськості якнайшвидше, щоб зробити її кращою швидше завдяки зворотному зв’язку.