Nvidia представляє «Chat with RTX», персональний чат-бот AI для Windows

Nvidia у вівторок анонсувала генеративний чат-бот з штучним інтелектом (genAI), який може працювати на ПК з Windows, що дає підприємствам можливість використовувати штучний інтелект у локальних середовищах співробітників для підвищення продуктивності замість того, щоб вимагати від них доступу до інструментів genAI на платформах, розміщених у таких провайдерів, як OpenAI.

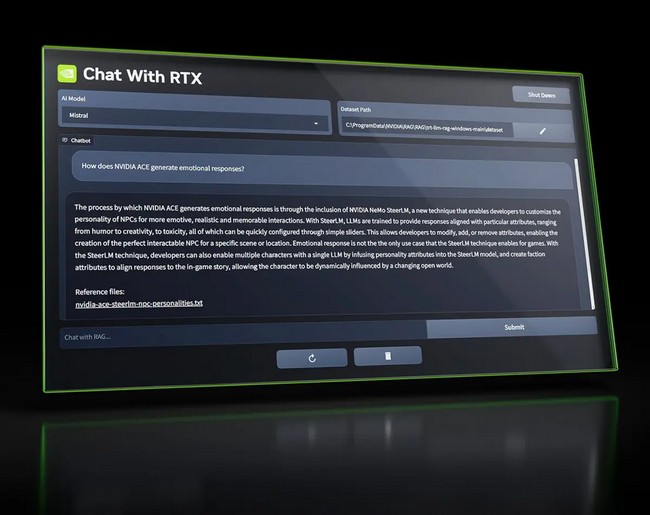

Виробник графічних чіпів випустив Chat with RTX , демо-додаток, який тепер доступний для безкоштовного завантаження; це дозволяє користувачам персоналізувати чат-бота за допомогою власного вмісту, в основному налаштовуючи джерела даних великих мовних моделей (LLM) бота. За словами Nvidia, це зберігає конфіденційні дані користувачів на їх ПК, допомагаючи їм швидко шукати відповіді на запитання на основі цих даних.

«Оскільки Chat with RTX працює локально на комп’ютерах і робочих станціях Windows RTX, результати надаються швидко — і дані користувача залишаються на пристрої», — написав Джессі Клейтон, менеджер із продуктів Nvidia, у дописі в блозі, рекламуючи чат-бота . «Замість того, щоб покладатися на хмарні служби LLM, Chat with RTX дозволяє користувачам обробляти конфіденційні дані на локальному ПК без необхідності ділитися ними з третьою стороною або мати підключення до Інтернету».

Chat with RTX дозволяє користувачам вибирати з двох LLM з відкритим кодом — Mistral або Llama 2 — і потребує графічного процесора Nvidia GeForce RTX серії 30 або вище з принаймні 8 ГБ відеопам’яті, що працює на Windows 10 або 11 з найновішими драйверами NVIDIA GPU. Чат-бот працює на ПК з ОС Windows на базі GEForce, використовуючи генерацію з доповненим пошуком (RAG), програмне забезпечення NVIDIA TensorRT-LLM і прискорення Nvidia RTX.

«Замість того, щоб шукати нотатки чи збережений вміст, користувачі можуть просто вводити запити», — написав Клейтон. «Наприклад, можна запитати: «Який ресторан рекомендував мій партнер під час перебування в Лас-Вегасі?» і Chat with RTX скануватиме локальні файли, на які вказує користувач, і надасть відповідь із контекстом».

Локальний персоналізований ШІ

Оскільки genAI продовжує швидко розвиватися, Nvidia позиціонує себе як провідного постачальника апаратного та програмного забезпечення для живлення та «демократизації» технології. Генеральний директор Nvidia Дженсен Хуанг сказав, що графічні процесори компанії зроблять ШІ доступним на багатьох платформах , від хмари до серверів і периферійних обчислень.

Схоже, чат із RTX узгоджується зі стратегією. Чат-бот підтримує різні формати файлів, включаючи текстові, pdf, doc/docx і xml. Користувачі можуть додавати дані до бібліотеки чат-бота, навівши програму на папку з файлами; через секунди вони будуть додані до бота.

Користувачі також можуть надати URL-адресу списку відтворення YouTube, і Chat with RTX завантажить транскрипції відео в списку відтворення, що дозволить людям запитувати вміст, який вони охоплюють.

Крім того, оскільки Chat with RTX побудовано на основі довідкового проекту TensorRT-LLM RAG для розробників, доступного на GitHub , розробники можуть створювати власні програми на основі RAG для платформи, повідомляє NVIDIA.

Вирішення проблеми конфіденційності

Застосування чат-ботів на основі genAI, таких як ChatGPT Open-AI, якими вже користуються мільйони людей у всьому світі трохи більше ніж через рік після випуску, зростає. Як і занепокоєння щодо безпеки та конфіденційності щодо чат-ботів, особливо після того, як у березні 2023 року в результаті витоку даних OpenAI було розкрито дані близько 1,2 мільйона передплатників, згідно з майбутнім звітом Menlo Security: « Постійний вплив генеративного штучного інтелекту на безпеку ».

Ідея локального персоналізованого чат-бота, який міг би підвищити продуктивність працівників, одночасно зменшуючи проблеми з конфіденційністю, безумовно, приваблива, сказав Джеймі Лоусон, головний менеджер із продуктів охоронної фірми.

«Це як мати власного персонального помічника зі штучним інтелектом прямо на вашому пристрої, який забезпечує конфіденційність і безпеку ваших розмов», — сказав він. «Зберігаючи дані та відповіді обмежено локальним середовищем користувача, існує значне зниження ризику викриття конфіденційної інформації ззовні».

Однак підприємствам доведеться стежити за даними, які співробітники вводять у свої LLM; Згідно зі звітом, багато хто вже робить це, розсилаючи працівникам політику відповідального використання генеративного ШІ. Тим не менш, співробітники наполегливо намагаються ввести конфіденційні корпоративні дані в LLM, що робить необхідним постійний нагляд, сказав Menlo Security.