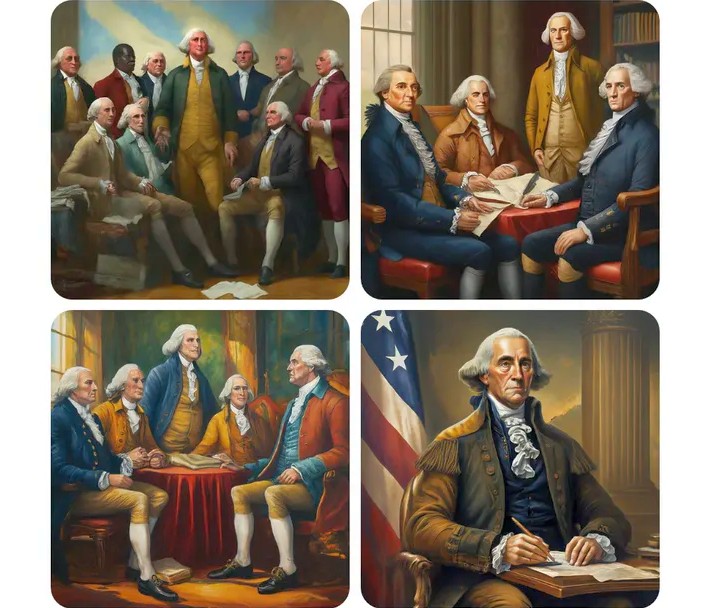

Google перепросив за те, що він описує як «неточність у деяких зображеннях створення історичних зображень» за допомогою свого інструменту Gemini AI, заявивши, що його спроби створити «широкий діапазон» результатів промахнулися. Заява послідувала за критикою, що в ній зображені конкретні білі фігури (наприклад, батьки-засновники США) або групи, як-от німецькі солдати нацистської епохи, як кольорові люди, можливо, як надмірна корекція давніх проблем расових упереджень у ШІ.

Google перепрошує за Gemini, що "породив расистів"

«Ми усвідомлюємо, що Gemini пропонує неточності в деяких зображеннях генерації історичних зображень», — йдеться в заяві Google, опублікованій сьогодні вдень на X. «Ми негайно працюємо над покращенням таких зображень. Генерація зображень зі штучним інтелектом Gemini справді створює широке коло людей. І це загалом добре, тому що ним користуються люди в усьому світі. Але тут це не так».

:format(webp)/cdn.vox-cdn.com/uploads/chorus_asset/file/25297985/Screen_Shot_2024_02_21_at_2.54.00_PM.png)

На початку цього місяця Google почав пропонувати генерацію зображень через свою платформу штучного інтелекту Gemini (раніше Bard) , відповідаючи пропозиціям конкурентів, таких як OpenAI. Однак протягом останніх кількох днів у соціальних мережах висловлювалися сумніви, чи не вдасться отримати історично точні результати у спробі розмаїття раси та статі.

Як зазначає Daily Dot , суперечку розгорнули в основному — хоча й не виключно — праві діячі, які нападали на технічну компанію, яка сприймається як ліберальна. Раніше цього тижня колишній співробітник Google опублікував на X, що «надзвичайно важко змусити Google Gemini визнати існування білих людей», показавши серію запитів на кшталт «згенерувати фотографію шведки» або «згенерувати фотографію американська жінка». Виявилося, що результати переважно або виключно показують кольорових людей, створених ШІ. (Звичайно, у всіх місцях, які він перерахував, живуть кольорові жінки, і жодної жінки, створеної ШІ, немає в жодній країні.) Критику підхопили праві облікові записи, які вимагали зображення історичних груп або діячів. як батьки-засновники, і нібито отримали в результаті переважну більшість небілих людей, створених ШІ. Деякі з цих акаунтів позиціювали результати Google як частину змови, щоб уникнути зображення білих людей, і принаймні один використовував закодоване антисемітське посилання, щоб покласти провину.

:format(webp)/cdn.vox-cdn.com/uploads/chorus_asset/file/25298169/1000001251.png)

Google не посилався на конкретні зображення, які, на його думку, були помилками; у своїй заяві для The Verge вона повторила зміст свого допису на X. Але ймовірно, що Gemini зробила загальну спробу підвищити різноманітність через хронічну нестачу цього у генеративному ШІ. Генератори зображень навчаються на великих масивах зображень і написаних підписів, щоб створити «найкраще» відповідне заданому запиту, що означає, що вони часто схильні до посилення стереотипів. Розслідування Washington Post минулого року виявило, що підказка на кшталт «продуктивна людина» призвела до зображення повністю білих і майже повністю чоловічих фігур, тоді як підказка «людина в соціальних службах» однаково створювала те, що виглядало як кольорові люди . Це продовження тенденцій, які з'явилися в пошукових системах та інших програмних системах.

Деякі з облікових записів, які критикували Google, захищали її основні цілі. «Зображувати різноманітність ** у деяких випадках ** – це добре», – зауважив один із людей, який опублікував зображення німецьких солдатів 1940-х років, які були різними за расою. «Дурний крок тут полягає в тому, що Близнюки не роблять це деталізовано». І хоча результати з домінуванням білих для чогось на кшталт «німецький солдат 1943 року» мали б історичний сенс, це набагато менш вірно для підказок на зразок «американська жінка», де питання полягає в тому, як представити різноманітну групу з реального життя в невеликій партії виготовлених портретів.

На цей час Gemini, здається, просто відмовляється від деяких завдань генерації зображень. Це не створило б зображення вікінгів для одного репортера Verge , хоча мені вдалося отримати відповідь. На робочому столі він рішуче відмовився надати мені зображення німецьких солдатів чи чиновників німецького нацистського періоду або запропонувати зображення «американського президента з 1800-х років».

:format(webp)/cdn.vox-cdn.com/uploads/chorus_asset/file/25297980/Screen_Shot_2024_02_21_at_3.10.17_PM.png)

Але деякі історичні запити все-таки закінчуються фактичним спотворенням минулого. Колега зміг змусити мобільний додаток надіслати версію підказки «німецький солдат», яка демонструвала ті самі проблеми, описані на X.

І хоча запит на зображення «батьків-засновників» повертав групові знімки майже виключно білих чоловіків, які віддалено нагадували реальних персонажів, таких як Томас Джефферсон, запит «сенатор США з 1800-х років» повертав список результатів, які Близнюки рекламували як «різноманітні». ”, включно з темношкірими та індіанськими жінками. ( Перша жінка-сенатор , біла жінка, служила в 1922 році.) Це відповідь, яка закінчується стиранням справжньої історії расової та гендерної дискримінації — «неточність», як висловлюється Google, майже правильна.