Развитие искусственного интеллекта может повысить уровень киберпреступности

Развитие технологий искусственного интеллекта может привести к появлению новых форм киберпреступности, политических беспорядков и даже физического насилия в течение пяти лет, предупредила группа из 26 экспертов со всего мира. Об этом сообщает The Guardian.

В новом докладе эксперты в области науки, промышленности, а также представители благотворительных организаций описывают ИИ как "технологию двойного назначения" для военного и гражданского использования, сродни ядерной энергии, взрывчаткам и хакерским ПО.

"Мы ожидаем, что использование систем искусственного интеллекта приведет к появлению, распространению и изменению типичного характера угроз", - сообщается в докладе.

Аналитики утверждают, что исследователи должны учитывать возможное злоупотребление ИИ в ходе своих исследований и работать над созданием надлежащих нормативных рамок для предотвращения вредоносного использования ИИ.

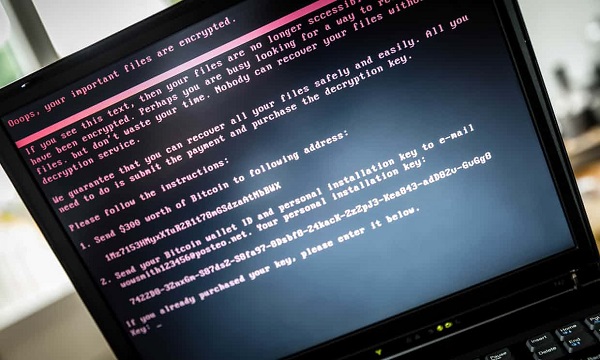

Если не соблюсти рекомендации, преступники могут воспользоваться ИИ в своих целях. Например, ИИ может автоматизировать обнаружение критических ошибок программного обеспечения или выбирать потенциальных жертв для финансовых преступлений. Кроме того, ИИ способен проводить атаки, используя методы социальной инженерии.

Растущий уровень влияния искусственного интеллекта на физический мир означает, что ИИ также можно злоупотреблять. Яркий пример – используемый в качестве оружия "рой дронов", несущих взрывчатку.

В докладе утверждается, что возможны и политические беспорядки. Государства могут решить использовать автоматизированные платформы наблюдения для подавления инакомыслия – например, как в Китае. Другие правительства могут создавать "автоматизированные, гипер-персонализированные кампании дезинформации", ориентированные на каждого отдельного избирателя, с определенной ложью, предназначенной для влияния на их поведение. Или же ИИ может генерировать огромное количество фейковых новостей, и тогда увидеть правдивую информацию станет практически невозможно.

"Мы живем в мире, который может стать опасным из-за неправильного использования искусственного интеллекта. Нам нужно взять на себя ответственность за эти проблемы - потому что риски более чем реальны. Есть выбор, который нам нужно сделать сейчас, и наш отчет - это призыв к действиям для правительств, учреждений и для каждого человека по всему миру", - пишет аналитик Сиан Хейдеартаг.

"На протяжении многих десятилетий обмана было больше, чем правды в отношении машинного обучения и ИИ. Больше этого не должно быть. В этом отчете предлагаются подходы, которые могут помочь: например, как разрабатывать программное обеспечение и аппаратуру, чтобы сделать их менее подверженным взломам; и какие законы и международные правила могут регулировать работу ИИ", - считает Сиан.

Однако не все убеждены, что ИИ представляет такой риск. "Будут улучшения с обеих сторон; это постоянная гонка вооружений. Искусственный интеллект чрезвычайно полезен уже сейчас – для сферы кибербезопасности. Конечно, ИИ "поможет" и преступникам. Остается выяснить, какая сторона получит от этого больше пользы – я считаю, что больше выгоды от развития ИИ получит оборонительная сторона", - прокомментировал соучредитель CrowdStrike Дмитрий Альперович.

По мнению экспертов, защита, основанная на использовании искусственного интеллекта, не является панацеей, особенно, когда мы выходим за пределы цифрового мира. "Необходимо проделать большую работу по установлению правильного баланса в развитии ИИ и разработке улучшенных технических мер для проверки надежности систем. Кроме того, нужно удостовериться, что политическая структура адаптирована к новому миру, который мы создаем", - утверждают аналитики в докладе.